La comunicación corporativa en el sector sanitario ha superado un umbral que marca un antes y un después. Desde la irrupción de modelos de lenguaje generativo a finales de 2022, la Inteligencia Artificial (IA) se ha convertido en el motor de una transformación que promete agilizar procesos, optimizar la gestión informativa y personalizar contenidos a una escala nunca vista. De hecho, algunas organizaciones ya reportan un ahorro de hasta un 20% del tiempo en la producción de contenido gracias a estas herramientas. Sin embargo, esta sed de eficiencia es el punto de partida de un debate más profundo: la IA amplifica riesgos que pueden minar la confianza, la credibilidad y la coherencia institucional si no se establece un marco profesional y ético estricto. La integración de la IA en la estrategia digital de salud exige una responsabilidad sin fisuras.

El Rigor es innegociable: la trampa de la velocidad instantánea

La capacidad de la IA para generar textos o resúmenes en segundos es, a primera vista, la solución ideal ante la presión informativa constante. Mientras que la redacción de un post de 300 palabras puede llevar a un profesional más de cinco minutos, la tecnología lo despacha en menos de diez segundos. Pero esta velocidad es una trampa crítica en el sector sanitario. El uso irreflexivo de la IA puede conducir a inexactitudes ocasionales, interpretaciones sesgadas o formulaciones ambiguas, un riesgo inaceptable en cualquier comunicado de salud. Un matiz mal expresado puede generar alarma social o inducir a errores en las decisiones de la ciudadanía. Por este motivo, la inmediatez nunca puede desplazar al rigor científico y clínico. Es vital establecer un protocolo donde los profesionales de la comunicación sigan siendo quienes comprueban los datos y revisan las fuentes antes de dar por válido cualquier producto generado.

La comunicación sanitaria demanda un equilibrio particular entre la precisión técnica y la empatía profunda. Quienes están en procesos de salud necesitan información clara, respetuosa y libre de cualquier sensacionalismo. Aunque la IA está preparada para automatizar tareas rutinarias, como la composición de emails o el análisis de grandes volúmenes de datos, carece por completo de la comprensión real del contexto humano y emocional. El resultado, sin una edición humana, puede ser un mensaje percibido como frío, despersonalizado o totalmente ajeno a la realidad asistencial, especialmente al abordar temas de alta sensibilidad como enfermedades graves o el impacto de los ensayos clínicos. La estrategia digital salud debe buscar automatizar lo rutinario para liberar tiempo, permitiendo al comunicador enfocarse en las actividades de mayor valor añadido: la estrategia y la gestión sensible de la información.

Cuando el sesgo pone en riesgo la reputación

La IA opera mediante patrones aprendidos de vastos conjuntos de datos. Si estos datos de entrenamiento contienen sesgos culturales, de género, o socioeconómicos —algo habitual—, la IA los replicará y los amplificará en el contenido. En la comunicación de salud, esto se traduce en riesgos éticos graves: una simplificación excesiva de realidades complejas, la invisibilización de colectivos vulnerables o la perpetuación de estereotipos sin fundamento científico. Este escenario representa un grave riesgo reputacional que socava directamente la misión de equidad del sistema. La gestión de riesgos reputacionales comienza por auditar el contenido de IA, garantizando que este refleje los valores de inclusión de la institución.

La confianza es el activo más importante del sector sanitario. Si una institución delega la narrativa en un algoritmo sin una revisión editorial profunda, corre el peligro de diluir la singularidad de su marca, su tono y su conexión emocional. Si la mayoría de las organizaciones sanitarias recurren a los mismos recursos genéricos, el riesgo de perder la diferenciación es evidente.

Además, surge una cuestión fundamental de transparencia: las instituciones deben ser claras con sus públicos sobre el grado de intervención de la IA en la generación de contenidos. Esto es especialmente crucial en el ámbito público. Finalmente, en la gestión de crisis (incidentes, ciberataques), la voz humana es insustituible para explicar, reconocer limitaciones y transmitir la calma necesaria. Un error automatizado en esta etapa amplificaría el daño reputacional de forma irreversible.

Marco estratégico para el uso responsable de la IA

La integración de la IA en comunicación es una realidad ineludible. El punto de equilibrio reside en aprovechar su eficiencia sin sacrificar la responsabilidad humana y ética.

Para avanzar de forma segura, es imprescindible establecer un marco estratégico que guíe el uso de la IA en comunicación sanitaria:

- Validación clínica obligatoria. Todos los contenidos generados por IA deben pasar por un filtro de verificación de expertos de la salud.

- Límites claros. Se deben reservar las tareas de alto impacto (comunicados de crisis, notas de prensa de avances científicos) para la intervención y redacción humana completa.

- Formación proactiva. Capacitar a los equipos para que entiendan y detecten los riesgos éticos, los sesgos y los hallucinations de los modelos.

- Criterio editorial humano. Asegurar que la narrativa, los valores y el tono de la institución sigan siendo definidos y supervisados por el equipo de comunicación.

La tecnología ofrece herramientas poderosas, pero la confianza y la credibilidad —el pilar de toda estrategia digital salud— se construyen con decisiones humanas y una gestión de riesgos reputacionales rigurosa.

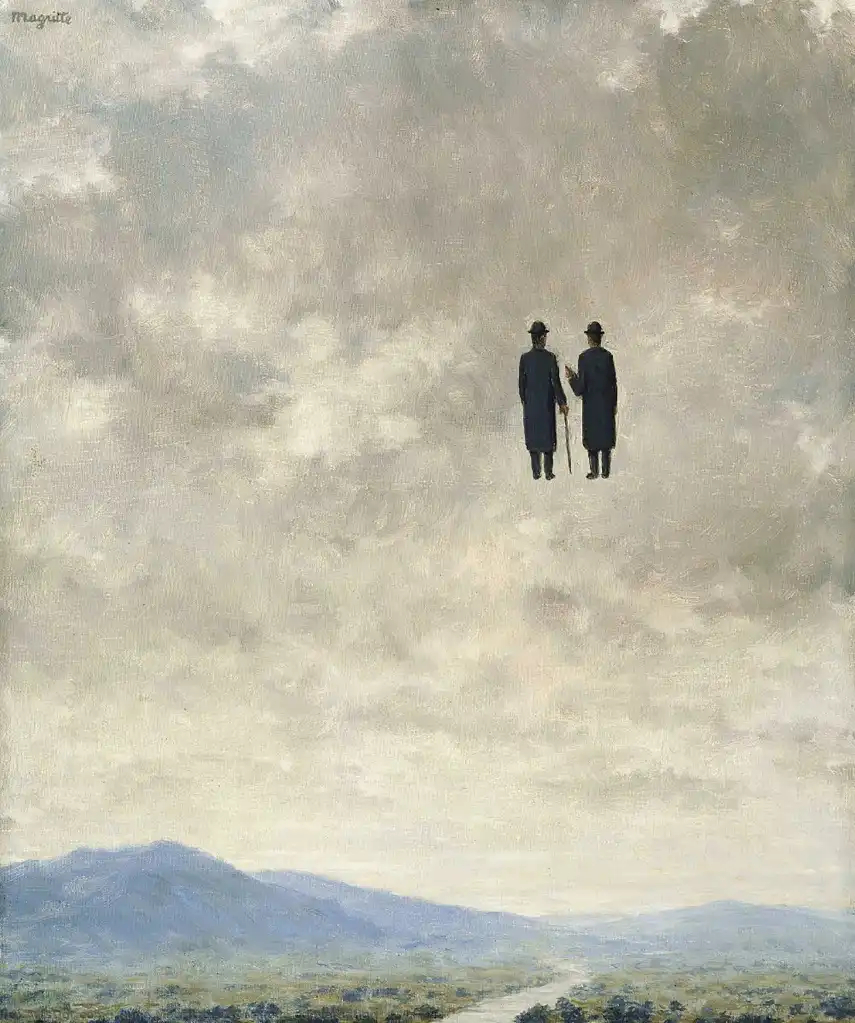

L’Art de la Conversation, René Magritte (1963)

Deja tu comentario